人工智能(Artificial Intelligence)

,英文缩写为AI。它是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。

AIGC 是继 UGC、PGC 之后新型利用AI技术自动生成内容的生产方式。

目前市场上AIGC一般可分为文本类、代码类、绘画类等等,那目前市场上有哪些公司在AIGC的绘画和文本和代码这些方向做得非常顶尖水平呢?当然有,那就是昆仑万维

,让我们看下他们的AIGC能力怎么样。

都让我们也可以用小程序,功能和PC效果一样。

小程序:天工巧绘SkyPaint

在主页,我们可以直接明了的看到 “生成画作”按钮,我们选一个“童话时间 白雪皑皑 圣诞节”的主题来进行AI绘制。

图片生成中

效果如下:

出现了4张圣诞节图片,非常清晰、操作也非常简单,最关键的是生成图片速度非常快,非常丝滑,一点也不卡,直接惊艳到我了。

我们输入“水天一色”这4个字,绘制效果如下。

3、输入英文关键字绘制

我们输入"red sky”英文,绘制效果如下。

小结 :从体验上讲,生成图片的速度非常快,并且能很好的支持中英双语提示词输入实现文字生成图像。

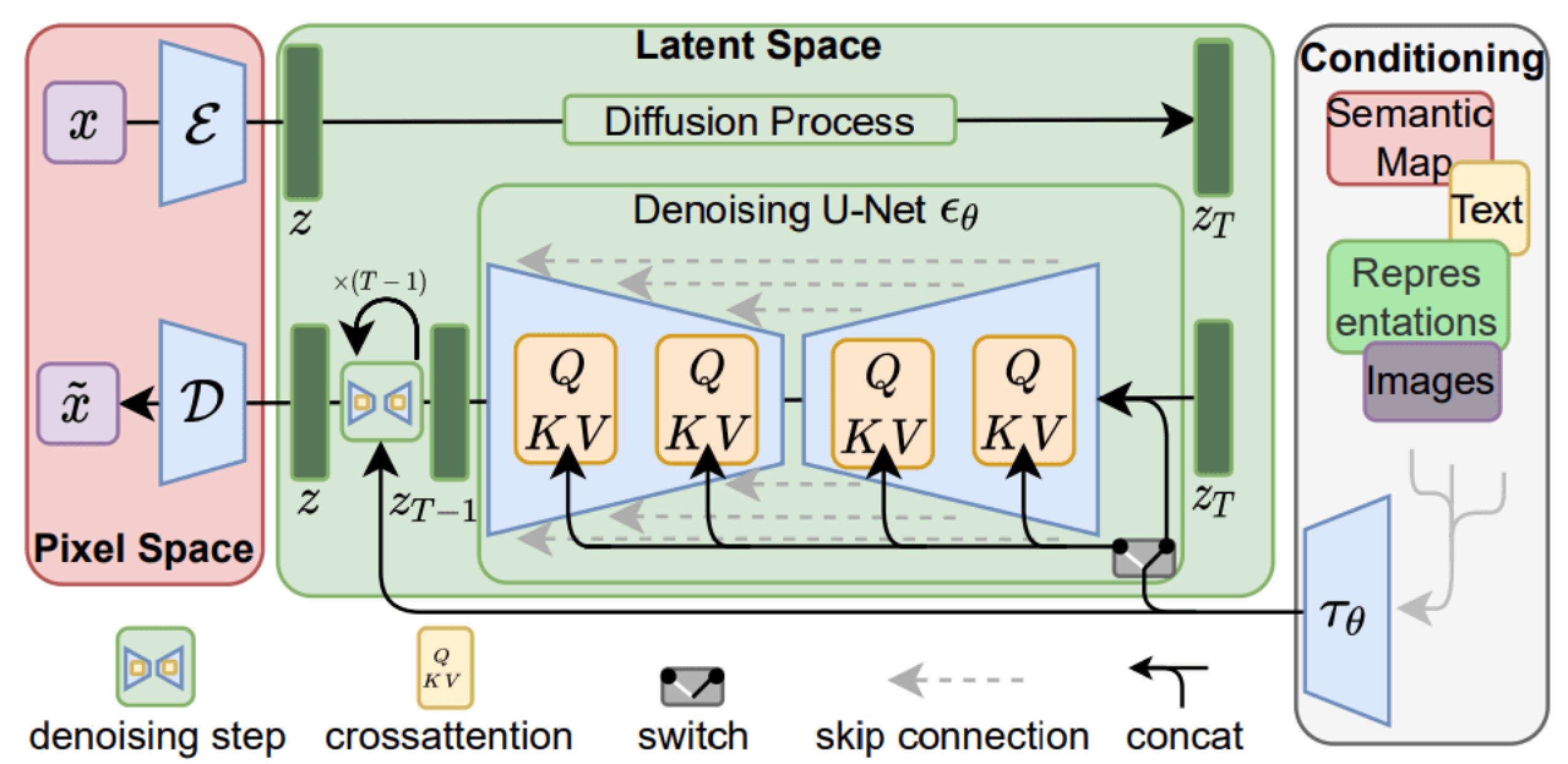

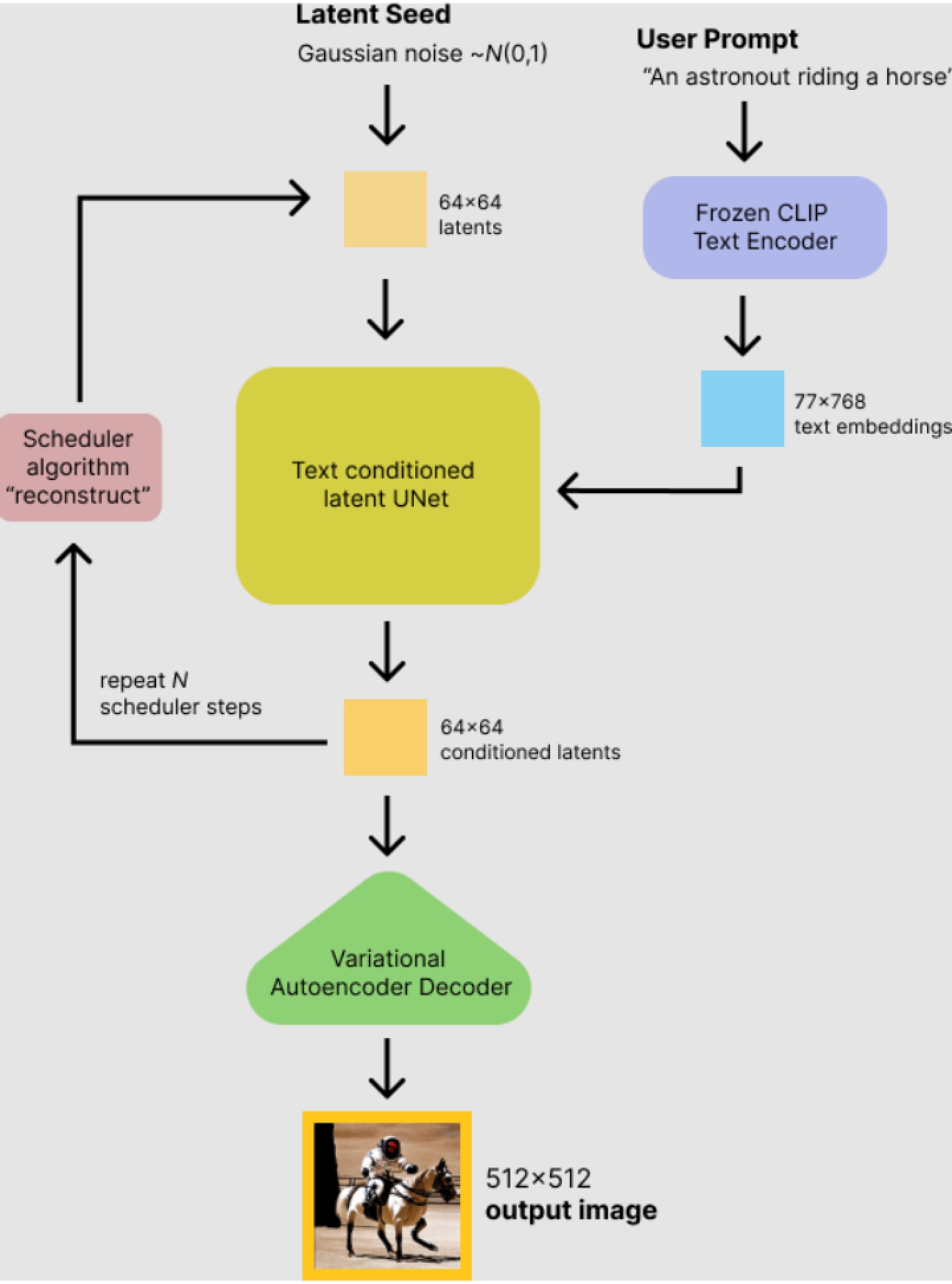

Model:Latent Diffusion

Paper:High-Resolution Image Synthesis with Latent Diffusion Models

训练集:LAION-high-resolution 和 LAION-Aesthetics

模型结构图:

模型原理

模型训练

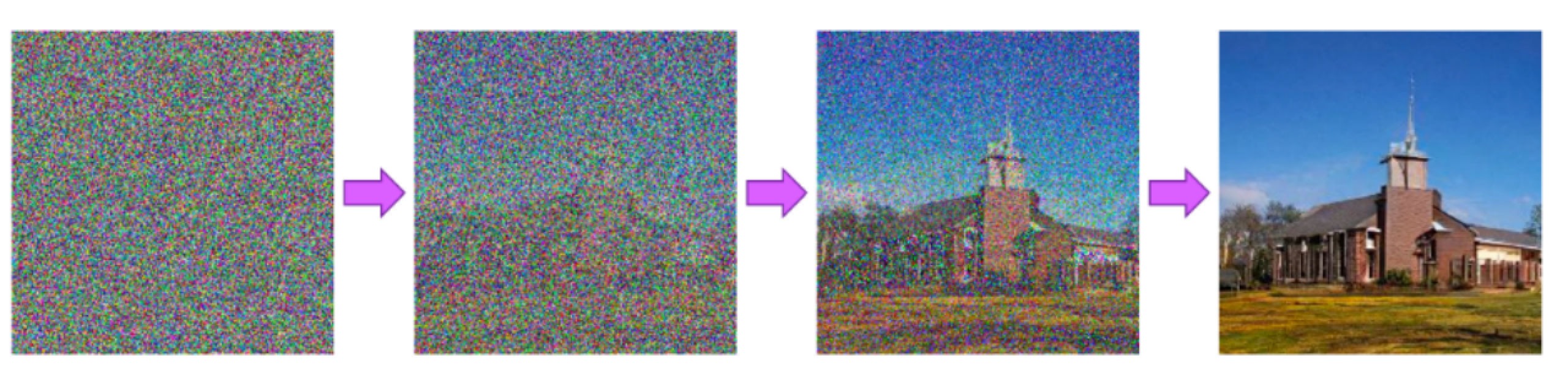

训练目标:一步步对随机的高斯噪声降噪(denoise)

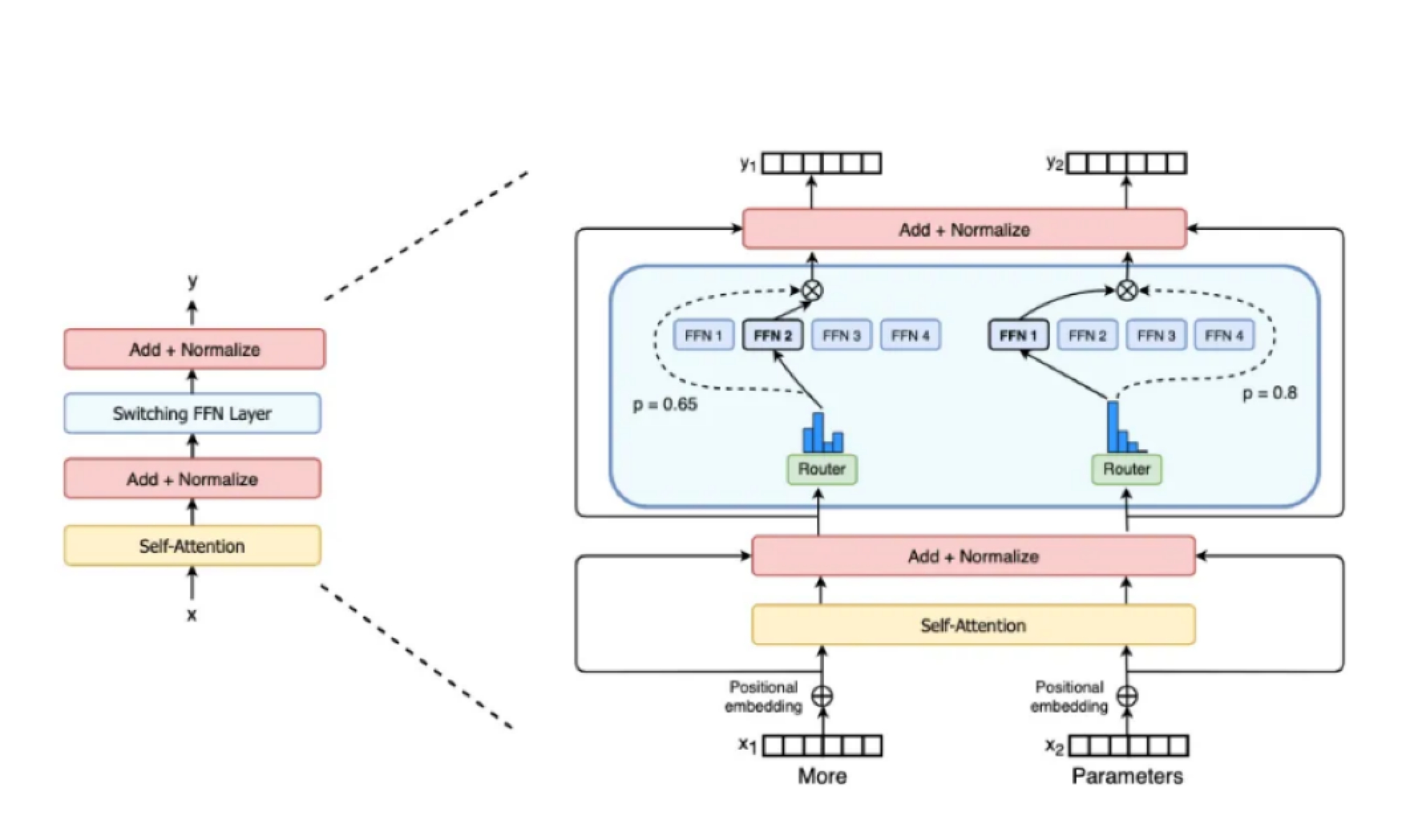

优势:Latent diffusion 之所以是 “latent”,是因为模型是在低维的潜空间(latent

space)上进行扩散过程,而不是在实际的像素空间,从而降低了内存消耗和计算复杂度(比如输入shape是(3,512,512),下采样因子是8,潜空间中变成了(3,64,64),节省了8×8=64倍的内存)。训练完之后的模型就能把一张图表示成一个低维的潜特征。

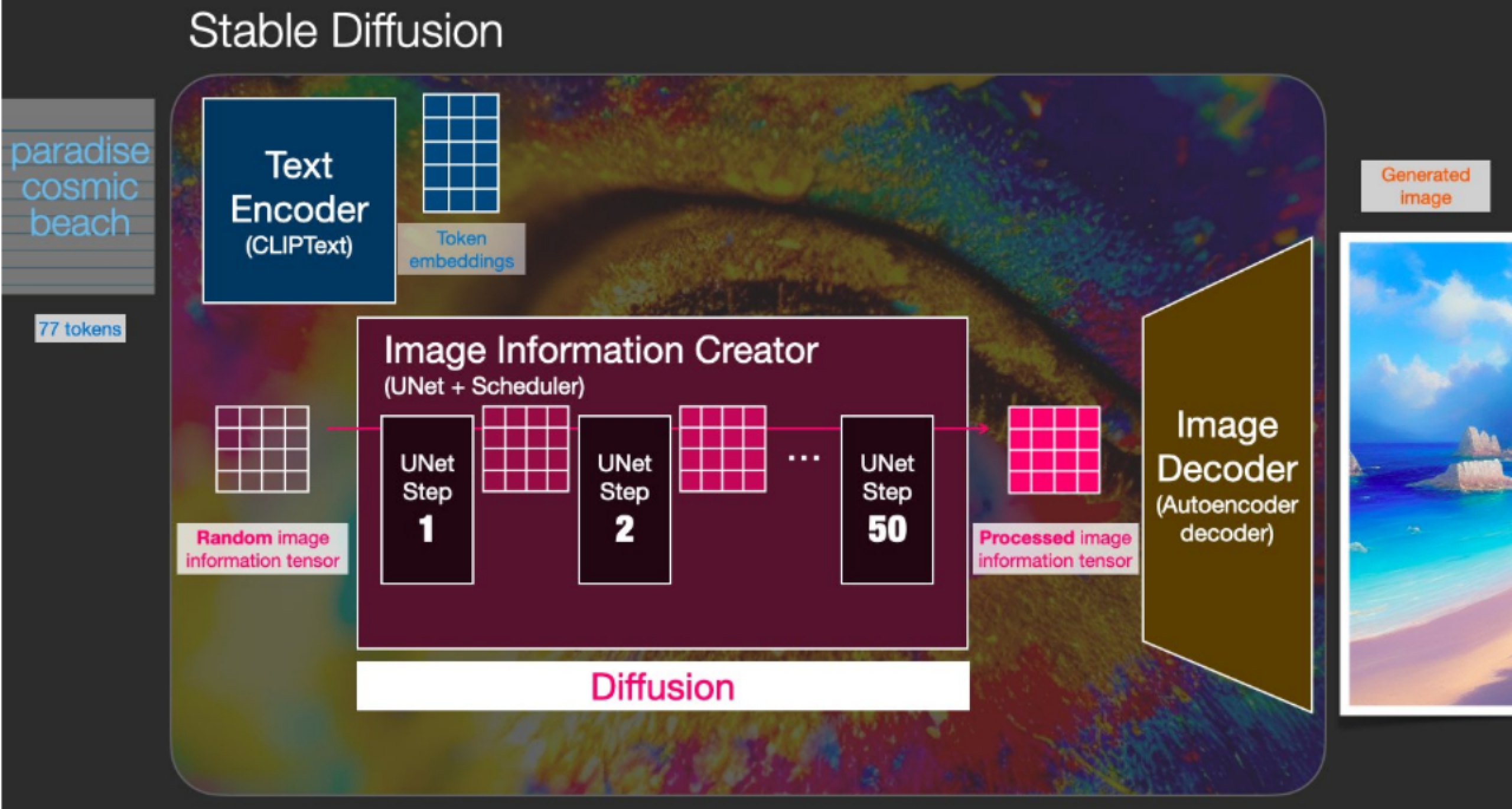

模型推理

如图(假设batch size是1),用户输入的 prompt 被 CLIP Text encoder 编码为 77×768 的潜特征,随机噪声被表示成

64×64 的潜特征;然后 U-Net 以 prompt 的特征为条件,逐步迭代计算。U-Net 输出的噪声残差,会通过调度算法(scheduler

algorithm),根据先前的噪声表示和预测的噪声残差,计算最终去噪的图像潜表示。Stable Diffusion 建议的调度算法有三种:

PNDM scheduler(Pseudo Numerical Methods for Diffusion Models on Manifolds,默认)

DDIM scheduler

K-LMS scheduler

得到图像潜表示后,就可以送到 VAE 的 decoder 解码成图像了。

• Stable Diffsuion能压缩率更高,清晰度超越JPEG等算法。

• 与纯粹基于transformer的方法相比,本文方法更适合高维数据;还可以高效地应用于百万像素图像的高分辨率合成。

•

显著降低计算成本,在多个任务(无条件图像合成、inpainting、超分辨率)和数据集上实现了具有竞争力的性能。与基于像素的扩散方法相比,显著降低了推理成本。

• 与之前的工作(同时学习编码器/解码器架构和score-

based的先验)相比,方法不需要对重构和生成能力进行精确的权衡。这确保了仅需非常少的潜空间正则化下,即可有较合理的重建效果。

• 对于超分辨率、图像修复和语义合成等条件密集输入型的任务,模型能以卷积的方式应用,并输出高达1024分辨率的图像。

• 基于交叉注意力的通用条件机制,实现了多模态训练。用它来训练类条件模型、文本到图像模型和布局到图像模型。

• Stable Diffsuion制作图片速度非常快。

总之只需训练一次通用的自动编码阶段,就可以用于多次DM训练或探索可能完全不同的任务,比如各种图像到图像、文本到图像任务。对于后者,设计了一个将transformers连接到DM的UNet骨干的结构,并支持任意类型的基于token的条件机制,就像有人已经投入了上百万的资金帮你训练了一个,你又何必重新花钱训练一个压缩模型呢?

1)、在增加中文提示词输入能力的同时兼容原版stable_diffusion的英文提示词模型,之前用户积累的英文提示词手册依然可以在我们的模型上使用

2)、使用1.5亿级别的平行语料优化提示词模型实现中英文对照,不仅涉及翻译任务语料,还包括了用户使用频率高的提示词中英语料,古诗词中英语料,字幕语料,百科语料,图片文字描述语料等多场景多任务的海量语料集合

3)、 训练时采用模型蒸馏方案和双语对齐方案,使用教师模型对学生模型蒸馏的同时辅以解码器语言对齐任务辅助模型训练"

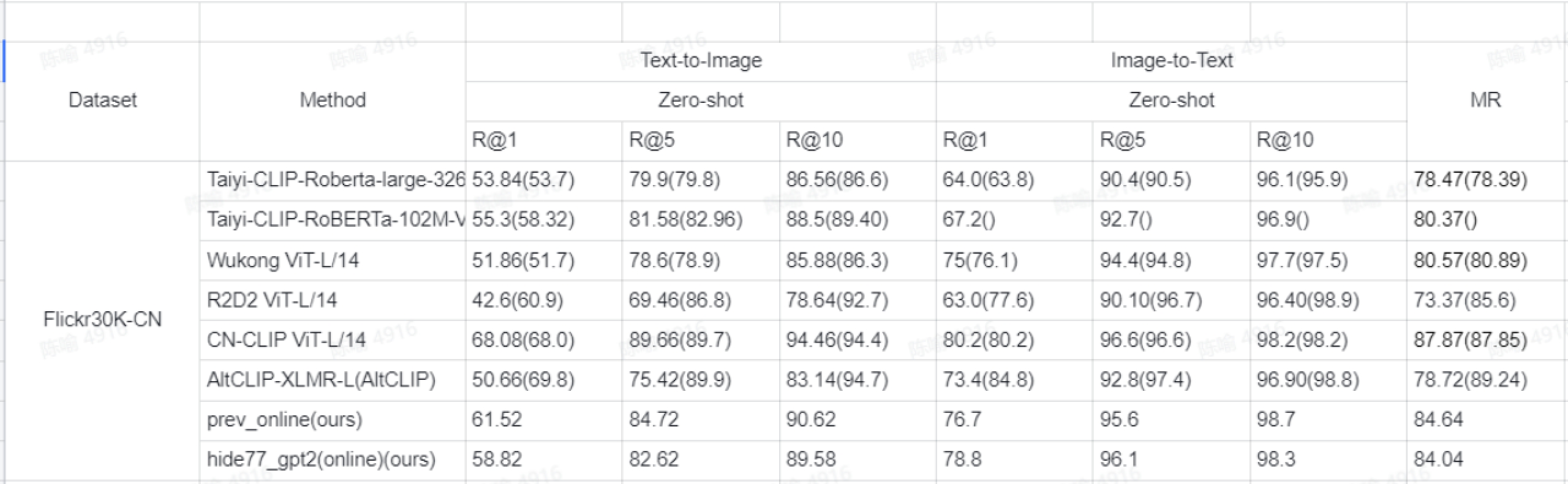

我们可以看下文字生成图片模型指标评估数据

评估背景:

未来的模型优化

为了让体验和算法模型变得更加强大,后续我们会针对下面4点去完善,希望能保持业界最高端水平。

• 更多语言的提示词输入支持

• 更强大的语言生成模型指导图像生成

• 风格更加多样,增加更多艺术风格的支持

• 支持用户对生成的图像进行二次提示词编辑图像功能

昆仑万维模型针对中文领域构建了千亿级别的高质量数据集,通过高性能 a100-GPU 集群训练得到了百亿

参数量的 GTP-3 生成模型,其几乎可以用于任何涉及理解或生成自然语言或代码的任务,同时提供了一

系列具有不同参数级别的模型,根据同任务进行适配,同时,也可以微调模型的得到适合需求的生成模

型。

文本模型指标评估

• GPT-3模型像人类一样对词语做出自己的理解

• GPT-3模型根据用户的喜好创作文学作品

• GPT-3模型根据用户的需求编写代码

• GPT-3比GPT-2有更好的文字质量,比GPT-2功能更加强大

• GPT-3模型可以进行创造性写作,展示了诗歌,对话文体,双关语使用,文学模仿和小说是其它模型不可比拟的

• GPT-3模型不是以传统的方式来使用已经存在的文本进行训练从而模仿文本,而可以通过对话方式告诉GPT-3用户想要什么样的内容。

总之通过了大部分课程的写作测试,而且仅仅需要 3-20

分钟,并且其中大部分时间用于对文本的输出长度和重复文本进行编辑。模型拥有多样的下游能力,包括续写,对话,中英翻译,内容风格生成,推理,诗词对联等。并在各项专业性领域的任务中(例如分类,匹配,填空,识别,识别)表现突出,与现有大模型的比试中排列前茅。

我们可以点击这个这里体验:

支持多种语言,这里我们使用 “内容续写 ” 使用下面的接口请求就行了,使用非常方便。

JSON{ “model_version”: “模型版本”, “prompt”: “写一篇小文章。\n今天的天气不错,我的心情”, “param”: {

“generate_length”: 500, “top_p”: 0.9, “top_k”: 50, “repetition_penalty”: 1.3,

“length_penalty”: 1, “min_len”: 10, “temperature”: 1, “end_words”: [ “[EOS]” ]

}}

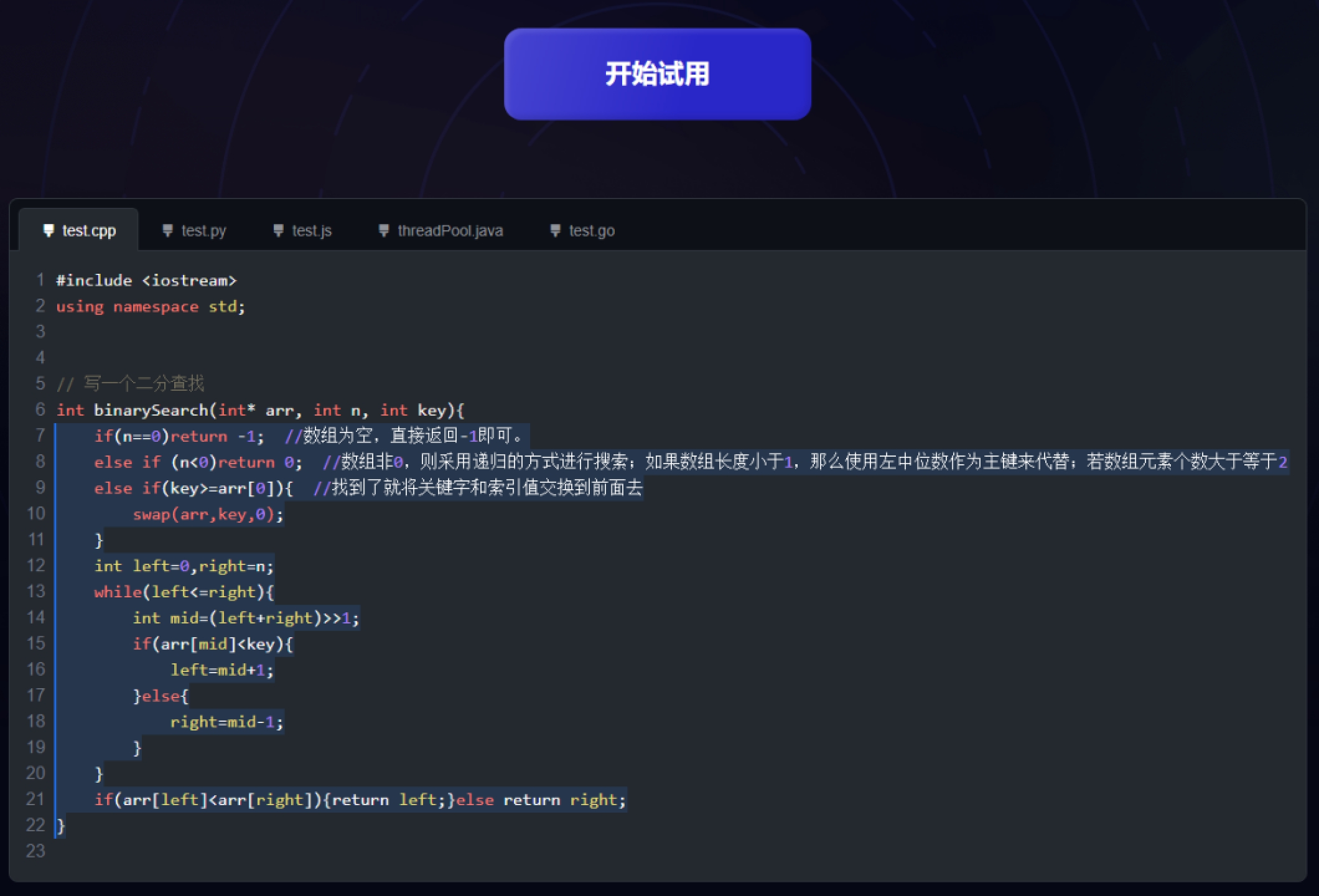

https://sky-code.singularity-ai.com/index.html#/

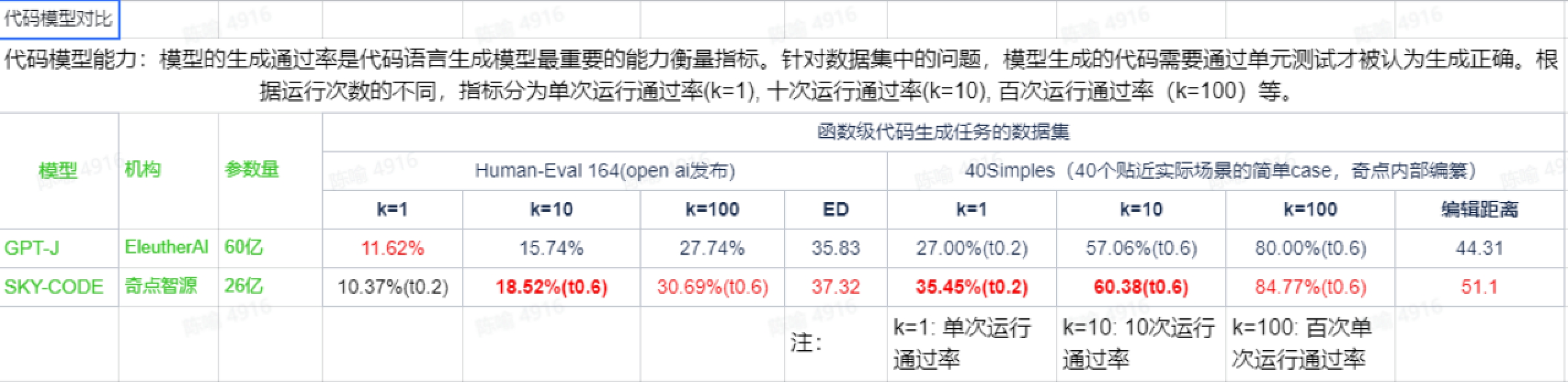

昆仑万维开发了全球第一款多语言开源编程大模型 Sky-code 代码生成工具,其支持各种主流编程语言,包括 java 、 javascript 、 c 、

c++ 、 python 、 go 和 shell 等编程语言,可以帮助开发人员更快更好的编码,甚至模型每秒可以输出百字以上的代码量,并且 Sky-

code模型的代码质量非常高,下表对比了 Sky-code 模型与其他代码生成模型的性能:

轻松上手

我们可以把sky-code安装到各个代码平台的编译器里面去,通过插件方式进行扩展,比如Visual Studio Code等。

Sky-code 是 SingularityAI 研发的一款AI代码生成工具,支持各种主流编程语言,助力开发人员更快更好的编码。Sky-code

可以直接集成到编辑器中,无缝衔接在开发环境,在键入代码的同时,智能高效补全代码,提升工作效率,节省开发时间。 Sky-code 目前已经集成在了

Visual Studio Code 中,未来会支持更多平台和工具,如 Neovim、JetBrains IDE、Visual Studio

等。致力于为开发者解决琐碎的、重复性的代码工作,从而专注于更高价值的研发工作,这是其它工具不可代替的。

通过上面的介绍,我们知道昆仑万维的AIGC无论是绘画还是文本还是代码生成,都拥有着非常强大和快而精准的算法模型,同时支持多语言进行绘画、和文本以及代码处理,简直就是业界的天花板,

强烈推荐大家使用。

Github

Huggingface

相关网站:

天工巧绘SkyPaint:

天工智码SkyCode:

天工妙笔SkyText:

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

保证100%免费】因篇幅问题不能全部显示,请点此查看更多更全内容